مولد Robots.txt

حول منشئ Robots.txt

منشئ Robots.txt هو أداة عبر الإنترنت تساعد مالكي مواقع الويب في إنشاء ملف Robots.txt لموقعهم على الويب. ملف Robots.txt هو ملف نصي عادي يتم وضعه في الدليل الجذر لموقع ويب لإعطاء إرشادات لبرامج زحف محركات البحث والوكلاء الآليين الآخرين حول كيفية الزحف إلى صفحات موقع الويب وفهرستها.

يتضمن ملف Robots.txt مجموعة من القواعد التي تحدد صفحات الويب والأدلة التي يجب الزحف إليها بواسطة محركات البحث وأيها يجب استبعاده. يمكن أيضًا استخدام الملف لتحديد موقع خريطة موقع الويب والملفات المهمة الأخرى.

لاستخدام هذه الأداة:

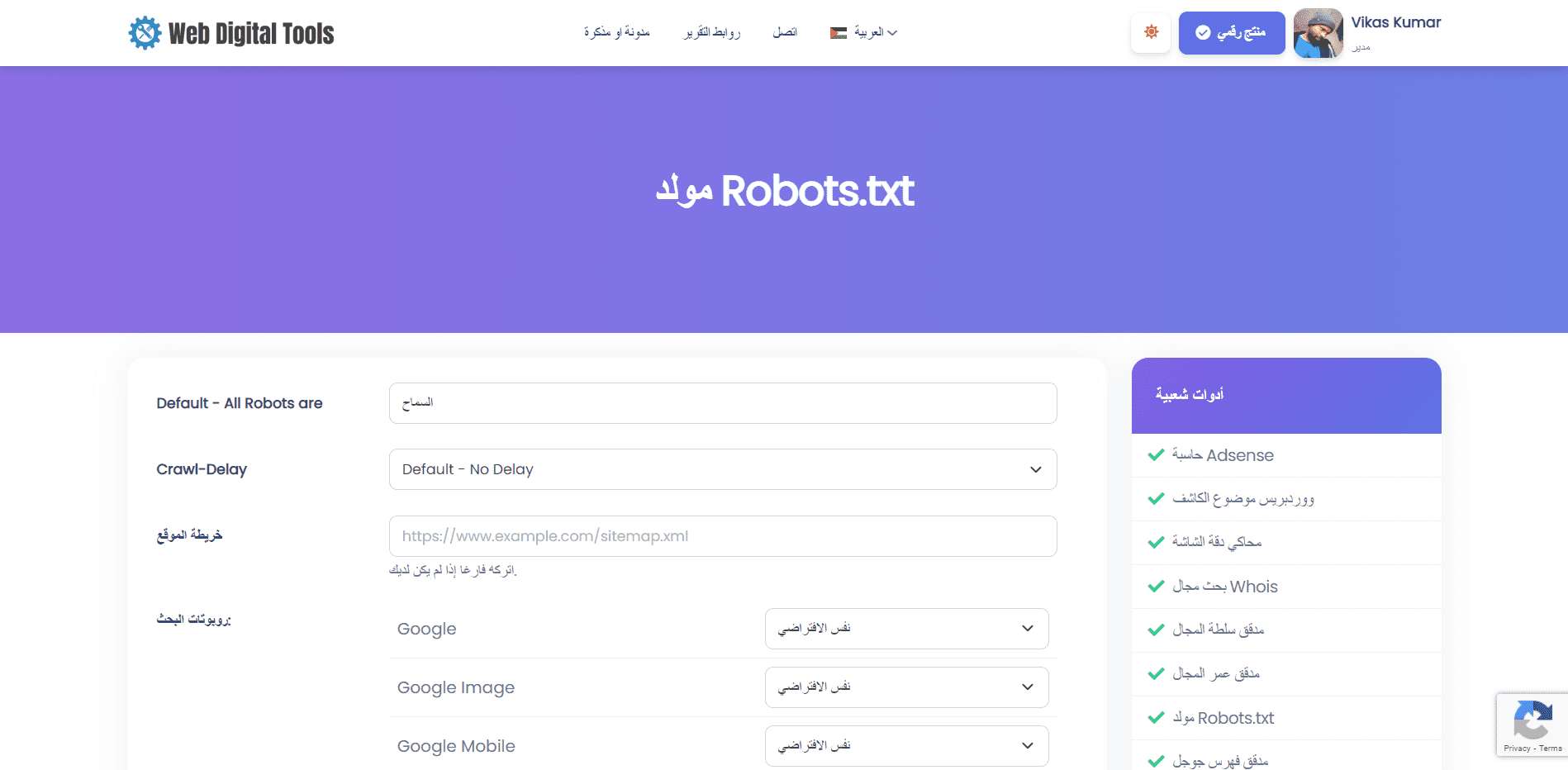

- انتقل إلى صفحة أداة منشئ Robots.txt.

- أدخل تفاصيل موقع الويب الخاص بك ، مثل عنوان URL لموقع الويب وعنوان URL لخريطة الموقع ووكيل المستخدم الذي تريد استهدافه.

- قم بتخصيص القواعد لملف Robots.txt الخاص بك ، مثل تحديد الدلائل والصفحات التي يجب السماح بها أو عدم السماح بها.

- انقر فوق الزر "إنشاء" لإنشاء ملف Robots.txt.

- انسخ الشفرة التي تم إنشاؤها والصقها في ملف نص عادي باسم "Robots.txt" ، ثم قم بتحميله إلى الدليل الجذر لموقعك على الويب.

يمكن أن تكون أداة "Robots.txt Generator" أداة مفيدة لأصحاب مواقع الويب الذين يرغبون في التأكد من أن محركات البحث يتم الزحف إليها وفهرستها بواسطة محركات البحث بطريقة محكمة وفعالة. باستخدام الأداة لإنشاء ملف Robots.txt مخصص ، يمكن لمالكي مواقع الويب التأكد من أن محركات البحث قادرة على الوصول إلى أهم الصفحات على موقع الويب الخاص بهم مع تجنب المحتوى المكرر والصفحات منخفضة الجودة والمشكلات الأخرى التي يمكن أن تؤثر على أداء تحسين محركات البحث. .

فهم بناء الجملة والتوجيهات

يعد فهم البنية والتوجيهات في ملف Robots.txt أمرًا مهمًا لمالكي مواقع الويب الذين يرغبون في إنشاء ملف Robots.txt باستخدام أداة منشئ Robots.txt أو تحرير ملف Robots.txt موجود.

يعتبر بناء جملة ملف Robots.txt بسيطًا نسبيًا. يتكون كل سطر من الملف من اسم وكيل مستخدم متبوعًا بتوجيه واحد أو أكثر. يحدد اسم وكيل المستخدم محرك البحث أو الزاحف الذي تنطبق عليه الأوامر. تحدد التوجيهات الصفحات والأدلة التي يجب السماح بها أو عدم السماح بها لوكيل المستخدم.

التوجيهات الأكثر شيوعًا في ملف Robots.txt هي:

-

وكيل المستخدم: يحدد هذا محرك البحث أو الزاحف الذي تنطبق عليه الأوامر. إذا كنت تريد تطبيق توجيه على جميع محركات البحث وبرامج الزحف ، فاستخدم علامة النجمة (*) كاسم وكيل المستخدم.

-

Disallow: يحدد هذا الصفحات أو الأدلة التي يجب ألا يتم الزحف إليها بواسطة وكيل المستخدم المحدد. يمكنك استخدام التوجيه Disallow لاستبعاد صفحات أو أدلة معينة من صفحات نتائج محرك البحث.

-

سماح: يحدد هذا الصفحات أو الأدلة التي يجب الزحف إليها بواسطة وكيل المستخدم المحدد. يمكنك استخدام الأمر Allow للسماح بصفحات أو دلائل معينة سيتم حظرها بواسطة توجيه Disallow.

-

خريطة الموقع: تحدد موقع خريطة موقع الويب. ملف Sitemap هو ملف يسرد جميع الصفحات الموجودة على موقع الويب التي يريد المالك فهرستها بواسطة محركات البحث.

-

تأخير الزحف: يحدد هذا التأخير بالثواني الذي يجب أن ينتظره وكيل المستخدم المحدد بين الطلبات المتتالية إلى موقع الويب. يمكن استخدام توجيه الزحف - تأخير للحد من معدل زحف محركات البحث إلى موقع الويب ، والذي يمكن أن يكون مفيدًا لمواقع الويب التي لديها موارد خادم محدودة.

من المهم ملاحظة أن بنية ملف Robots.txt وتوجيهاته حساسة لحالة الأحرف. بالإضافة إلى ذلك ، قد تفسر بعض محركات البحث التوجيهات بشكل مختلف ، لذلك من الجيد اختبار ملف Robots.txt باستخدام أداة مدقق Robots.txt للتأكد من أنه يعمل على النحو المنشود.

دعنا نجرب أداة إنشاء Robots.txt الخاصة بنا ونبلغنا إذا وجدت أي أخطاء.