Trình tạo Robots.txt

Giới thiệu về Trình tạo Robots.txt

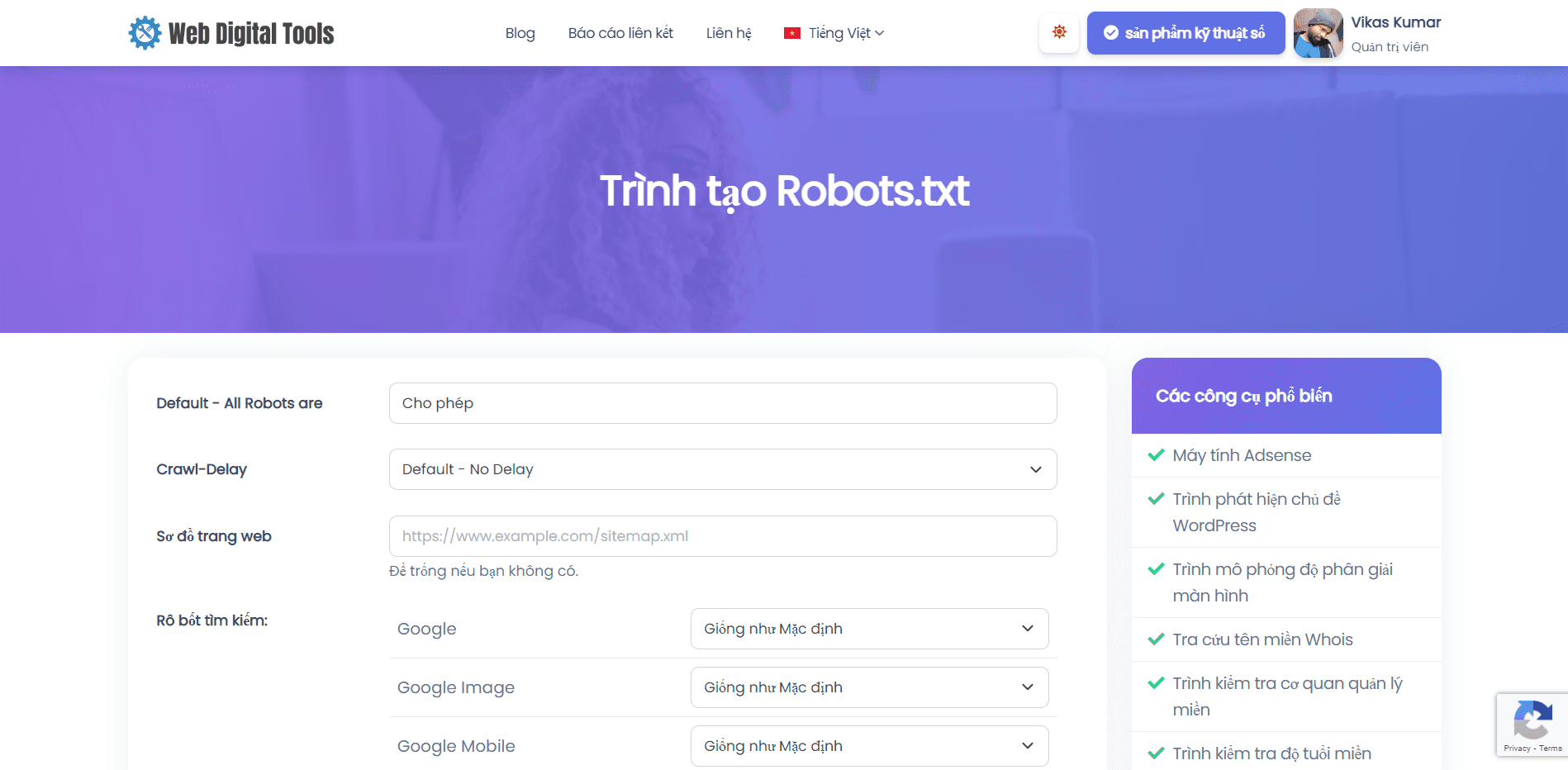

Trình tạo Robots.txt là một công cụ trực tuyến giúp chủ sở hữu trang web tạo tệp Robots.txt cho trang web của họ. Tệp Robots.txt là một tệp văn bản thuần túy được đặt trong thư mục gốc của trang web để cung cấp hướng dẫn cho trình thu thập dữ liệu của công cụ tìm kiếm và các tác nhân tự động khác về cách thu thập dữ liệu và lập chỉ mục các trang của trang web.

Tệp Robots.txt bao gồm một bộ quy tắc chỉ định những trang web và thư mục nào sẽ được công cụ tìm kiếm thu thập thông tin và những trang web và thư mục nào sẽ bị loại trừ. Tệp cũng có thể được sử dụng để chỉ định vị trí của sơ đồ trang web và các tệp quan trọng khác.

Để sử dụng công cụ này:

- Truy cập trang công cụ tạo Robots.txt.

- Nhập thông tin chi tiết về trang web của bạn, chẳng hạn như URL trang web, URL sơ đồ trang web và tác nhân người dùng mà bạn muốn nhắm mục tiêu.

- Tùy chỉnh các quy tắc cho tệp Robots.txt của bạn, chẳng hạn như chỉ định thư mục và trang nào sẽ cho phép hoặc không cho phép.

- Nhấp vào nút "Tạo" để tạo tệp Robots.txt.

- Sao chép mã được tạo và dán vào tệp văn bản thuần túy có tên "Robots.txt" và tải mã đó lên thư mục gốc của trang web của bạn.

Công cụ "Trình tạo Robots.txt" có thể là một công cụ hữu ích cho chủ sở hữu trang web muốn đảm bảo rằng trang web của họ được các công cụ tìm kiếm thu thập dữ liệu và lập chỉ mục theo cách có kiểm soát và hiệu quả. Bằng cách sử dụng công cụ để tạo tệp Robots.txt tùy chỉnh, chủ sở hữu trang web có thể đảm bảo rằng các công cụ tìm kiếm có thể truy cập các trang quan trọng nhất trên trang web của họ đồng thời tránh nội dung trùng lặp, trang chất lượng thấp và các vấn đề khác có thể ảnh hưởng đến hiệu suất SEO của họ .

Hiểu Cú pháp & Chỉ thị

Việc hiểu cú pháp và chỉ thị trong tệp Robots.txt rất quan trọng đối với chủ sở hữu trang web muốn tạo tệp Robots.txt bằng công cụ tạo Robots.txt hoặc chỉnh sửa tệp Robots.txt hiện có.

Cú pháp của tệp Robots.txt tương đối đơn giản. Mỗi dòng của tệp bao gồm một tên tác nhân người dùng, theo sau là một hoặc nhiều chỉ thị. Tên tác nhân người dùng chỉ định công cụ tìm kiếm hoặc trình thu thập thông tin mà các lệnh áp dụng. Các lệnh chỉ định những trang và thư mục nào sẽ được phép hoặc không được phép đối với tác nhân người dùng.

Các lệnh phổ biến nhất trong tệp Robots.txt là:

-

Tác nhân người dùng: Điều này chỉ định công cụ tìm kiếm hoặc trình thu thập thông tin mà các lệnh áp dụng. Nếu bạn muốn áp dụng một lệnh cho tất cả các công cụ tìm kiếm và trình thu thập dữ liệu, hãy sử dụng dấu hoa thị (*) làm tên tác nhân người dùng.

-

Không cho phép: Điều này chỉ định những trang hoặc thư mục nào sẽ không được thu thập thông tin bởi tác nhân người dùng được chỉ định. Bạn có thể sử dụng lệnh Disallow để loại trừ các trang hoặc thư mục cụ thể khỏi các trang kết quả của công cụ tìm kiếm.

-

Cho phép: Điều này chỉ định những trang hoặc thư mục nào sẽ được thu thập thông tin bởi tác nhân người dùng được chỉ định. Bạn có thể sử dụng lệnh Allow để cho phép các trang hoặc thư mục cụ thể mà nếu không sẽ bị chặn bởi lệnh Disallow.

-

Sơ đồ trang web: Điều này chỉ định vị trí của sơ đồ trang web. Sơ đồ trang web là một tệp liệt kê tất cả các trang trên trang web mà chủ sở hữu muốn được lập chỉ mục bởi các công cụ tìm kiếm.

-

Crawl-delay: Điều này chỉ định độ trễ tính bằng giây mà tác nhân người dùng được chỉ định sẽ đợi giữa các yêu cầu liên tiếp đến trang web. Chỉ thị Crawl-delay có thể được sử dụng để giới hạn tốc độ mà các công cụ tìm kiếm thu thập dữ liệu trang web, điều này có thể hữu ích cho các trang web có tài nguyên máy chủ hạn chế.

Điều quan trọng cần lưu ý là cú pháp và lệnh của tệp Robots.txt phân biệt chữ hoa chữ thường. Ngoài ra, một số công cụ tìm kiếm có thể diễn giải các lệnh theo cách khác, vì vậy, bạn nên kiểm tra tệp Robots.txt bằng công cụ kiểm tra Robots.txt để đảm bảo rằng tệp đang hoạt động như dự định.

Hãy dùng thử công cụ tạo Robots.txt của chúng tôi và báo cáo cho chúng tôi nếu bạn tìm thấy bất kỳ lỗi nào.