Генератор robots.txt

О генераторе robots.txt

Генератор Robots.txt — это онлайн-инструмент, который помогает владельцам веб-сайтов создавать файл Robots.txt для своего веб-сайта. Файл Robots.txt — это обычный текстовый файл, который помещается в корневой каталог веб-сайта и содержит инструкции для сканеров поисковых систем и других автоматизированных агентов о том, как сканировать и индексировать страницы веб-сайта.

Файл Robots.txt содержит набор правил, определяющих, какие веб-страницы и каталоги должны сканироваться поисковыми системами, а какие должны быть исключены. Этот файл также можно использовать для указания местоположения карты сайта веб-сайта и других важных файлов.

Чтобы использовать этот инструмент:

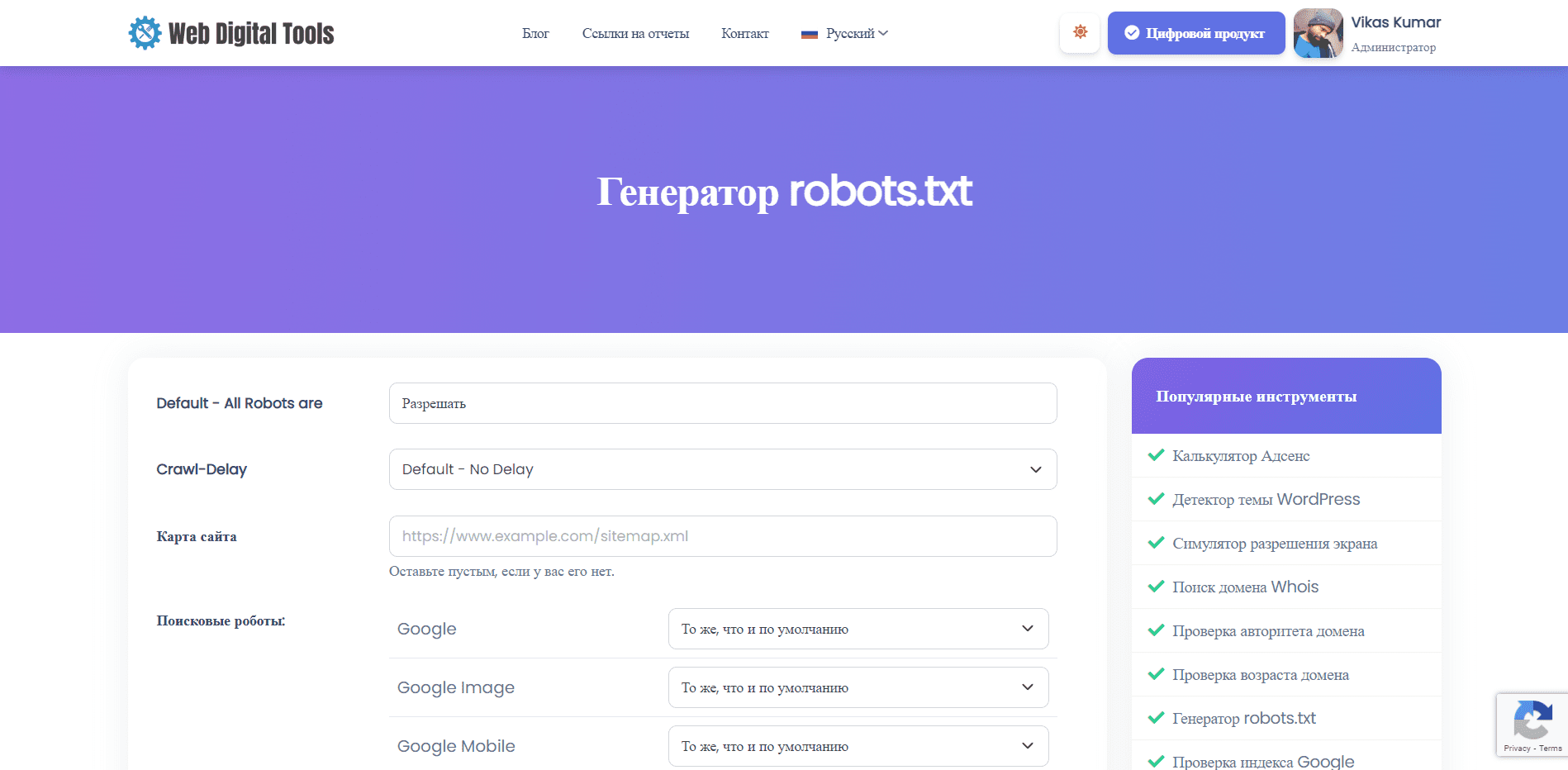

- Перейдите на страницу генератора Robots.txt.

- Введите сведения о своем веб-сайте, такие как URL-адрес веб-сайта, URL-адрес карты сайта и пользовательский агент, на который вы хотите настроить таргетинг.

- Настройте правила для файла Robots.txt, например укажите, какие каталоги и страницы разрешать или запрещать.

- Нажмите кнопку «Создать», чтобы создать файл Robots.txt.

- Скопируйте сгенерированный код и вставьте его в обычный текстовый файл с именем «Robots.txt» и загрузите его в корневой каталог вашего веб-сайта.

Инструмент «Генератор Robots.txt» может быть полезным инструментом для владельцев веб-сайтов, которые хотят убедиться, что их веб-сайт сканируется и индексируется поисковыми системами контролируемым и эффективным образом. Используя инструмент для создания настраиваемого файла Robots.txt, владельцы веб-сайтов могут гарантировать, что поисковые системы смогут получить доступ к наиболее важным страницам своего веб-сайта, избегая дублирования контента, некачественных страниц и других проблем, которые могут повлиять на их эффективность SEO. .

Понимание синтаксиса и директив

Понимание синтаксиса и директив в файле Robots.txt важно для владельцев веб-сайтов, которые хотят создать файл Robots.txt с помощью генератора Robots.txt или отредактировать существующий файл Robots.txt.

Синтаксис файла Robots.txt относительно прост. Каждая строка файла состоит из имени пользовательского агента, за которым следует одна или несколько директив. Имя пользовательского агента указывает поисковую систему или сканер, к которым применяются директивы. Директивы определяют, какие страницы и каталоги должны быть разрешены или запрещены для пользовательского агента.

Наиболее распространенные директивы в файле Robots.txt:

-

Пользовательский агент: указывает поисковую систему или сканер, к которым применяются директивы. Если вы хотите применить директиву ко всем поисковым системам и сканерам, используйте звездочку (*) в качестве имени пользовательского агента.

-

Запретить: указывает, какие страницы или каталоги не должны сканироваться указанным пользовательским агентом. Вы можете использовать директиву Disallow, чтобы исключить определенные страницы или каталоги из страниц результатов поисковой системы.

-

Разрешить: Это указывает, какие страницы или каталоги должны быть просканированы указанным пользовательским агентом. Вы можете использовать директиву Allow, чтобы разрешить определенные страницы или каталоги, которые в противном случае были бы заблокированы директивой Disallow.

-

Карта сайта: указывает расположение карты сайта веб-сайта. Карта сайта — это файл, в котором перечислены все страницы веб-сайта, которые владелец хочет проиндексировать поисковыми системами.

-

Crawl-delay: указывает задержку в секундах, которую указанный пользовательский агент должен ожидать между последовательными запросами к веб-сайту. Директиву Crawl-delay можно использовать для ограничения скорости, с которой поисковые системы сканируют веб-сайт, что может быть полезно для веб-сайтов с ограниченными ресурсами сервера.

Важно отметить, что синтаксис и директивы файла Robots.txt чувствительны к регистру. Кроме того, некоторые поисковые системы могут по-разному интерпретировать директивы, поэтому рекомендуется протестировать файл Robots.txt с помощью средства проверки Robots.txt, чтобы убедиться, что он работает должным образом.

Давайте попробуем наш генератор Robots.txt и сообщим нам, если обнаружите какие-либо ошибки.