Gerador Robots.txt

Sobre o Gerador Robots.txt

Um gerador de Robots.txt é uma ferramenta online que ajuda os proprietários de sites a criar um arquivo Robots.txt para seus sites. Um arquivo Robots.txt é um arquivo de texto simples que é colocado no diretório raiz de um site para fornecer instruções aos rastreadores de mecanismos de pesquisa e outros agentes automatizados sobre como rastrear e indexar as páginas do site.

O arquivo Robots.txt inclui um conjunto de regras que especificam quais páginas da Web e diretórios devem ser rastreados pelos mecanismos de pesquisa e quais devem ser excluídos. O arquivo também pode ser usado para especificar a localização do sitemap do site e outros arquivos importantes.

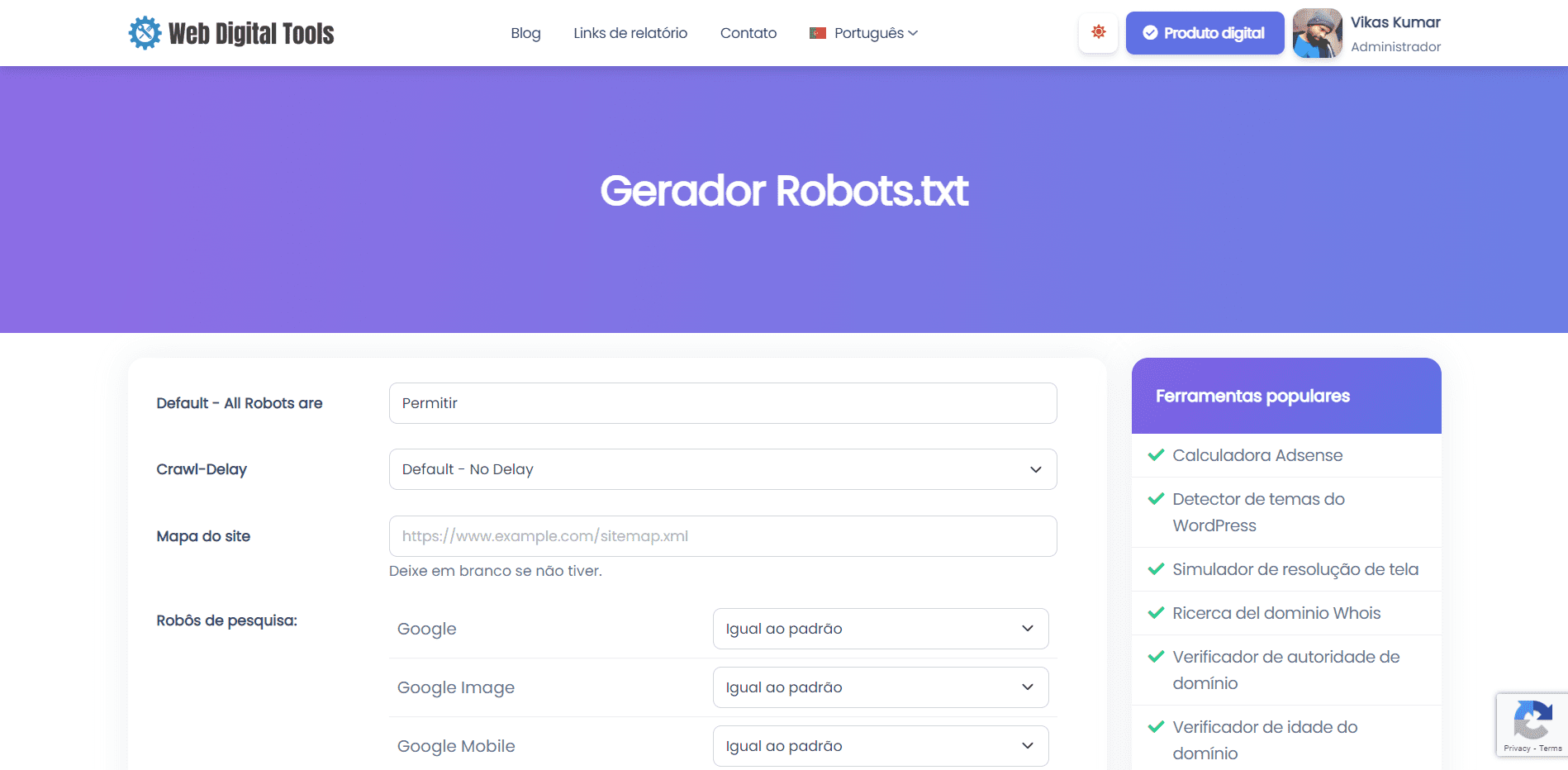

Para usar esta ferramenta:

- Vá para a página da ferramenta do gerador Robots.txt.

- Insira os detalhes do seu site, como o URL do site, o URL do mapa do site e o agente do usuário que você deseja segmentar.

- Personalize as regras para seu arquivo Robots.txt, como especificar quais diretórios e páginas permitir ou não.

- Clique no botão "Gerar" para criar o arquivo Robots.txt.

- Copie o código gerado e cole-o em um arquivo de texto simples chamado "Robots.txt" e faça o upload para o diretório raiz do seu site.

A ferramenta "Gerador Robots.txt" pode ser uma ferramenta útil para proprietários de sites que desejam garantir que seu site seja rastreado e indexado pelos mecanismos de pesquisa de maneira controlada e eficiente. Ao usar a ferramenta para criar um arquivo Robots.txt personalizado, os proprietários de sites podem garantir que os mecanismos de pesquisa possam acessar as páginas mais importantes de seus sites, evitando conteúdo duplicado, páginas de baixa qualidade e outros problemas que podem afetar seu desempenho de SEO .

Entendendo a sintaxe e as diretivas

Compreender a sintaxe e as diretivas em um arquivo Robots.txt é importante para proprietários de sites que desejam criar um arquivo Robots.txt usando uma ferramenta geradora de Robots.txt ou editar um arquivo Robots.txt existente.

A sintaxe de um arquivo Robots.txt é relativamente simples. Cada linha do arquivo consiste em um nome de agente do usuário seguido por uma ou mais diretivas. O nome do agente do usuário especifica o mecanismo de pesquisa ou rastreador ao qual as diretivas se aplicam. As diretivas especificam quais páginas e diretórios devem ser permitidos ou não para o agente do usuário.

As diretivas mais comuns em um arquivo Robots.txt são:

-

User-agent: especifica o mecanismo de pesquisa ou rastreador ao qual as diretivas se aplicam. Se você deseja aplicar uma diretiva a todos os mecanismos de pesquisa e rastreadores, use um asterisco (*) como o nome do agente do usuário.

-

Não permitir: especifica quais páginas ou diretórios não devem ser rastreados pelo agente do usuário especificado. Você pode usar a diretiva Disallow para excluir páginas ou diretórios específicos das páginas de resultados do mecanismo de pesquisa.

-

Permitir: especifica quais páginas ou diretórios devem ser rastreados pelo agente do usuário especificado. Você pode usar a diretiva Allow para permitir páginas ou diretórios específicos que, de outra forma, seriam bloqueados por uma diretiva Disallow.

-

Mapa do site: especifica a localização do mapa do site do site. O mapa do site é um arquivo que lista todas as páginas do site que o proprietário deseja que sejam indexadas pelos mecanismos de pesquisa.

-

Atraso de rastreamento: especifica o atraso em segundos que o agente do usuário especificado deve aguardar entre solicitações sucessivas ao site. A diretiva Crawl-delay pode ser usada para limitar a taxa na qual os mecanismos de pesquisa rastreiam o site, o que pode ser útil para sites com recursos de servidor limitados.

É importante observar que a sintaxe e as diretivas de um arquivo Robots.txt diferenciam maiúsculas de minúsculas. Além disso, alguns mecanismos de pesquisa podem interpretar as diretivas de maneira diferente, por isso é uma boa ideia testar o arquivo Robots.txt usando uma ferramenta de verificação do Robots.txt para garantir que esteja funcionando conforme o esperado.

Vamos experimentar nossa ferramenta geradora de Robots.txt e informar-nos se você encontrou algum erro.