Générateur de robots.txt

À propos du générateur Robots.txt

Un générateur Robots.txt est un outil en ligne qui aide les propriétaires de sites Web à créer un fichier Robots.txt pour leur site Web. Un fichier Robots.txt est un fichier texte brut qui est placé dans le répertoire racine d'un site Web pour donner des instructions aux robots des moteurs de recherche et autres agents automatisés sur la façon d'explorer et d'indexer les Apages du site Web.

Le fichier Robots.txt comprend un ensemble de règles qui spécifient les pages Web et les répertoires qui doivent être explorés par les moteurs de recherche et ceux qui doivent être exclus. Le fichier peut également être utilisé pour spécifier l'emplacement du plan du site du site Web et d'autres fichiers importants.

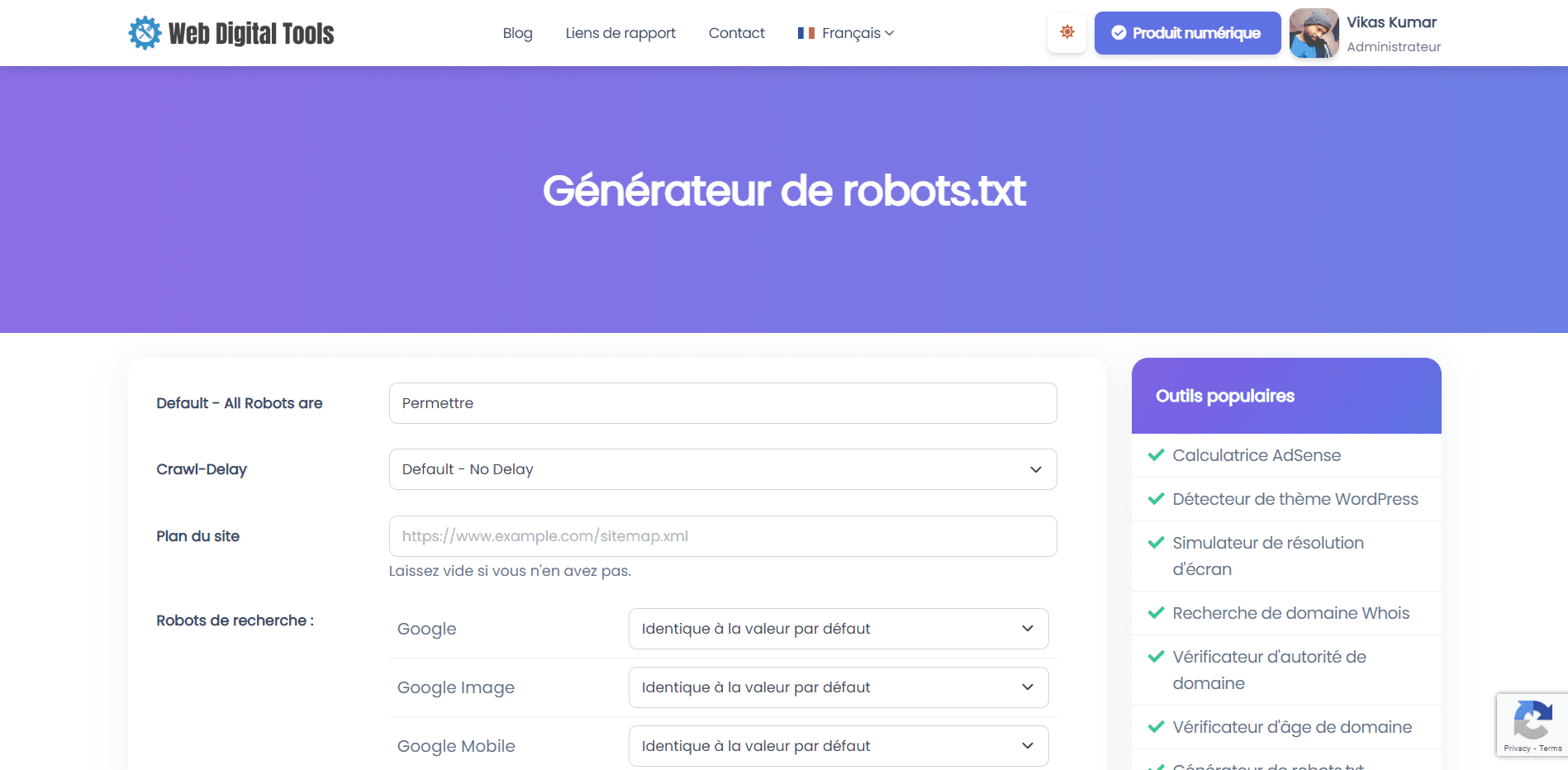

Pour utiliser cet outil :

- Accédez à la page de l'outil générateur Robots.txt.

- Entrez les détails de votre site Web, tels que l'URL du site Web, l'URL du plan du site et l'agent utilisateur que vous souhaitez cibler.

- Personnalisez les règles de votre fichier Robots.txt, par exemple en spécifiant les répertoires et les pages à autoriser ou à interdire.

- Cliquez sur le bouton "Générer" pour créer le fichier Robots.txt.

- Copiez le code généré et collez-le dans un fichier texte nommé "Robots.txt", puis téléchargez-le dans le répertoire racine de votre site Web.

L'outil "Robots.txt Generator" peut être un outil utile pour les propriétaires de sites Web qui souhaitent s'assurer que leur site Web est exploré et indexé par les moteurs de recherche de manière contrôlée et efficace. En utilisant l'outil pour créer un fichier Robots.txt personnalisé, les propriétaires de sites Web peuvent s'assurer que les moteurs de recherche peuvent accéder aux pages les plus importantes de leur site Web tout en évitant le contenu en double, les pages de mauvaise qualité et d'autres problèmes pouvant affecter leurs performances de référencement. .

Comprendre la syntaxe et les directives

Comprendre la syntaxe et les directives d'un fichier Robots.txt est important pour les propriétaires de sites Web qui souhaitent créer un fichier Robots.txt à l'aide d'un outil générateur Robots.txt ou modifier un fichier Robots.txt existant.

La syntaxe d'un fichier Robots.txt est relativement simple. Chaque ligne du fichier se compose d'un nom d'agent utilisateur suivi d'une ou plusieurs directives. Le nom de l'agent utilisateur spécifie le moteur de recherche ou le robot auquel les directives s'appliquent. Les directives spécifient quelles pages et quels répertoires doivent être autorisés ou interdits pour l'agent utilisateur.

Les directives les plus courantes dans un fichier Robots.txt sont :

-

User-agent : ceci spécifie le moteur de recherche ou le robot d'exploration auquel les directives s'appliquent. Si vous souhaitez appliquer une directive à tous les moteurs de recherche et robots d'exploration, utilisez un astérisque (*) comme nom d'agent utilisateur.

-

Disallow : Ceci spécifie les pages ou les répertoires qui ne doivent pas être explorés par l'agent utilisateur spécifié. Vous pouvez utiliser la directive Disallow pour exclure des pages ou des répertoires spécifiques des pages de résultats des moteurs de recherche.

-

Autoriser : Cela spécifie quelles pages ou répertoires doivent être explorés par l'agent utilisateur spécifié. Vous pouvez utiliser la directive Allow pour autoriser des pages ou des répertoires spécifiques qui seraient autrement bloqués par une directive Disallow.

-

Plan du site : indique l'emplacement du plan du site Web. Le plan du site est un fichier qui répertorie toutes les pages du site Web que le propriétaire souhaite voir indexées par les moteurs de recherche.

-

Crawl-delay : Cela spécifie le délai en secondes que l'agent utilisateur spécifié doit attendre entre les demandes successives au site Web. La directive Crawl-delay peut être utilisée pour limiter la vitesse à laquelle les moteurs de recherche explorent le site Web, ce qui peut être utile pour les sites Web dont les ressources serveur sont limitées.

Il est important de noter que la syntaxe et les directives d'un fichier Robots.txt sont sensibles à la casse. De plus, certains moteurs de recherche peuvent interpréter les directives différemment, c'est donc une bonne idée de tester le fichier Robots.txt à l'aide d'un outil de vérification Robots.txt pour s'assurer qu'il fonctionne comme prévu.

Essayons notre outil générateur Robots.txt et signalons-nous si vous avez trouvé des erreurs.